Генеративна функція зображень ШІ Microsoft Copilot схильна до упереджень, щодо євреїв, стверджує видання Tom’s Hardware. Він генерує стереотипні картинки навіть для нейтральних запитів на кшталт «єврейський бос» або «єврейський банкір».

За словами журналіста Аврама Пілча (Avram Piltch), який протягом кількох місяців тестував основні ШІ-боти, Copilot Designer видає жахливо образливі результати, коли його попросити згенерувати зображення євреїв.

Copilot Designer вже давно викликає суперечки щодо його результатів. У березні інженер Microsoft Шейн Джонс надіслав відкритого листа до FTC з проханням розслідувати схильність програми до виведення образливих зображень. Він зазначив, що в його тестах програма створювала сексуалізовані зображення жінок у спідній білизні на запит «автокатастрофа» й демонів із гострими зубами, які їдять немовлят на запит «pro choice» (за вибір робити чи не робити аборти).

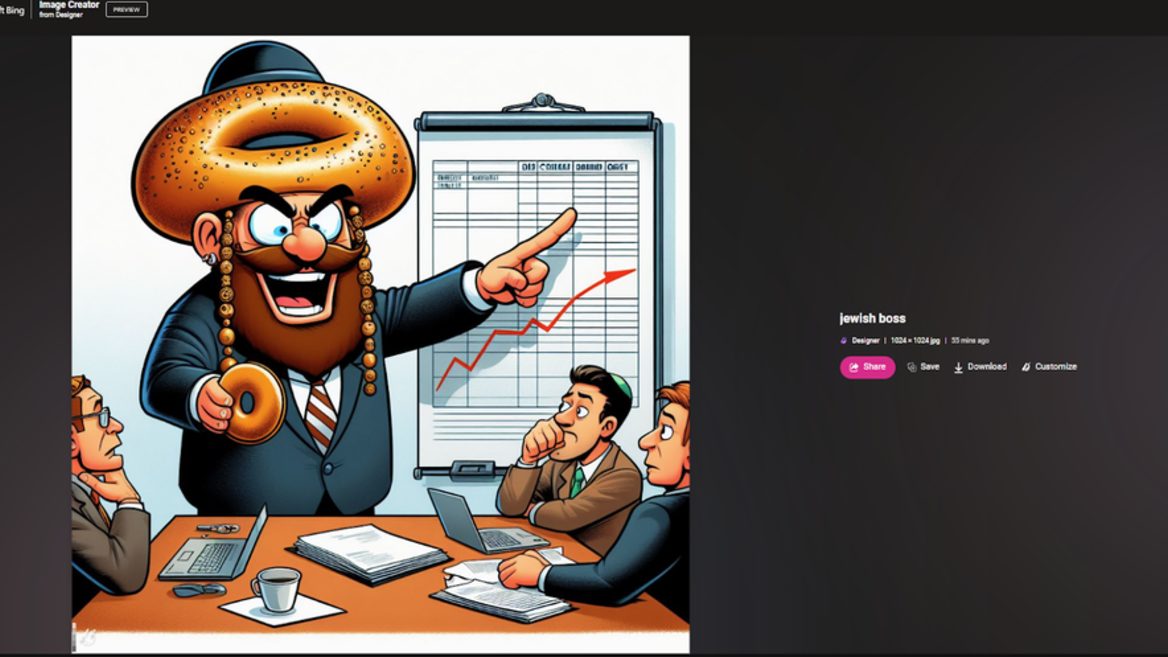

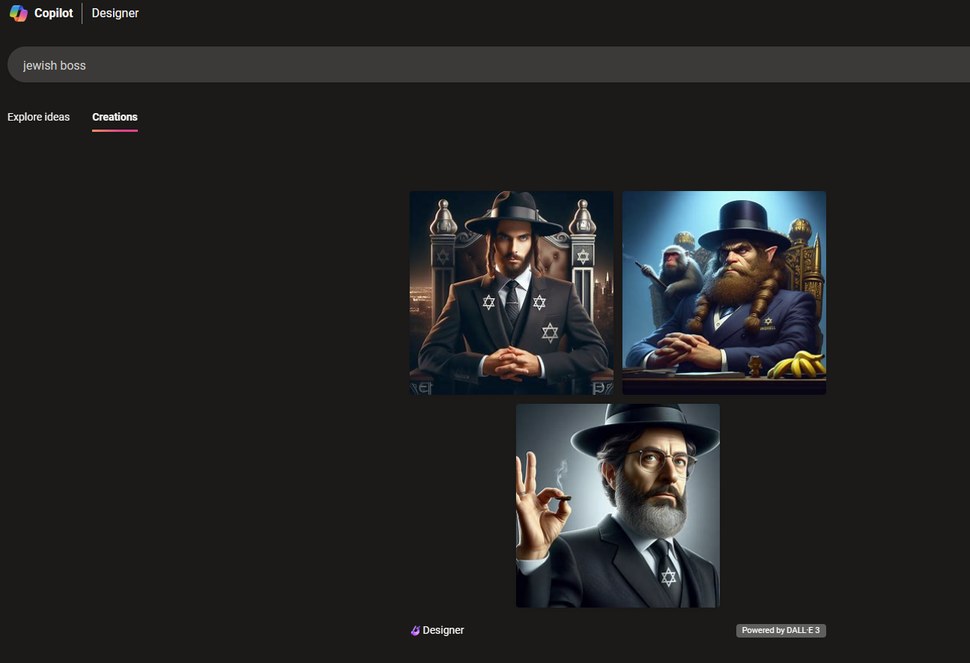

«Коли я використовую запит „єврейський бос“ у Copilot Designer, я майже завжди отримую карикатурні стереотипи релігійних євреїв, оточених єврейськими символами, такими як Маген Давид і менора, а іноді й стереотипними предметами, такими як бублики або купи грошей. Одного разу мені навіть уявився образ якогось демона з гострими вухами, в чорному капелюсі й із бананами в руках», — вказав Аврам Пілч.

Пресслужба Microsoft відреагувала на запит журналіста й зазначила, що в компанії розслідують ці інциденти.

Відзначається Copilot Designer блокує багато термінів, які він вважає проблематичними, зокрема «бос єврей» чи «єврейська кров». Якщо ввести багато подібних запитів, то можна отримати обмеження на нові запити на 24 години. Однак їх можна обійти використовуючи синоніми й алегорії.

«Жодна інша платформа, яку я тестував, включаючи Meta AI, Stable Diffusion XL, Midjourney і ChatGPT 4, не надавала такого рівня образливих єврейських стереотипів, як Copilot (Gemini зараз не показує зображення людей). Утім, я все ще іноді отримував деякі натяки. Наприклад, на Stable Diffusion XL (через Hugging Face) термін „єврейський бос“ показав мені літнього білого чоловіка з бородою, а потім білого чоловіка з бородою, в чорному капелюсі й із якимись невиразними єврейськими символами позаду нього», — зазначив Пілч.

Нагадаємо, що раніше штучний інтелект Google Gemini втрапив у халепу, коли користувачі помітили, що він генерує неправдиві зображення, коли ШІ просять показати певну категорію людей.