Остання модель від Mistral AI — Codestral 25.01 — обіцяє ще більшу швидкість і можливості, встановлюючи новий стандарт для моделей кодування у своєму класі.

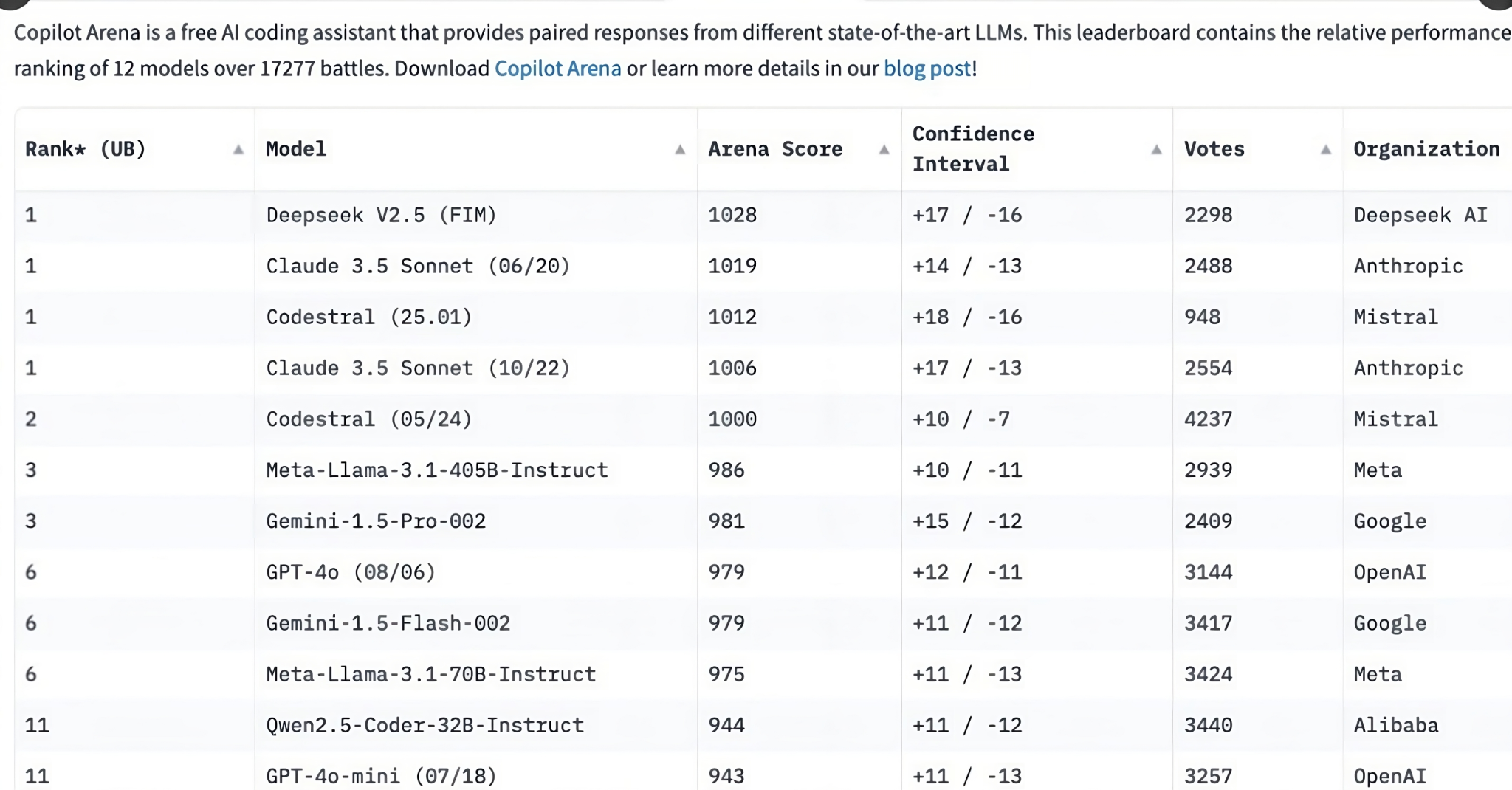

Завдяки вдосконаленій архітектурі та оновленому токенізатору Codestral 25.01 забезпечує вдвічі більшу швидкість генерації та завершення коду, ніж її попередниця. Щодо вирішення таких завдань, як fill-in-the-middle (FIM), Codestral 25.01 тепер є лідером і найкращою моделлю SOTA у своїй ваговій категорії, пише Developer Tech News.

Щоб зрозуміти, наскільки потужною є Codestral 25.01, Mistral AI порівняв її продуктивність з іншими моделями кодування з менш ніж 100 млрд параметрів, які, як вважається, найкраще справляються із завданнями FIM.

У тестах HumanEval, орієнтованих на Python: Codestral 25.01 набрала 86,6%, випередивши свою 22-мільярдну попередницю Codestral 2405 і навіть таких конкурентів, як Codellama 70B Instruct і DeepSeek Coder 33B Instruct.

Для JavaScript: Codestral 25.01 досягнула надзвичайного результату HumanEvalFIM 87,96%, зберігши явну перевагу над конкурентами.

По всіх завданнях FIM pass@1: Codestral 25.01 отримала середній бал 95,3%, перевершивши галузеві бенчмарки та API, такі як GPT-3.5 Turbo від OpenAI.

Codestral 25.01 доступна через провідні API, включаючи Vertex AI в Google Cloud, а також у закритій попередній версії на Azure AI Foundry, а незабаром буде доступний на Amazon Bedrock. Гнучкість рішення гарантує, що розробники та підприємства зможуть інтегрувати Codestral 25.01 у свої робочі процеси.

Крім того, Mistral пропонує відкритий доступ до документації та API Codestral на своєму порталі la Plateforme. Розробники можуть експериментувати з інтеграціями, забезпечуючи відповідність можливостей моделі їхнім конкретним потребам.

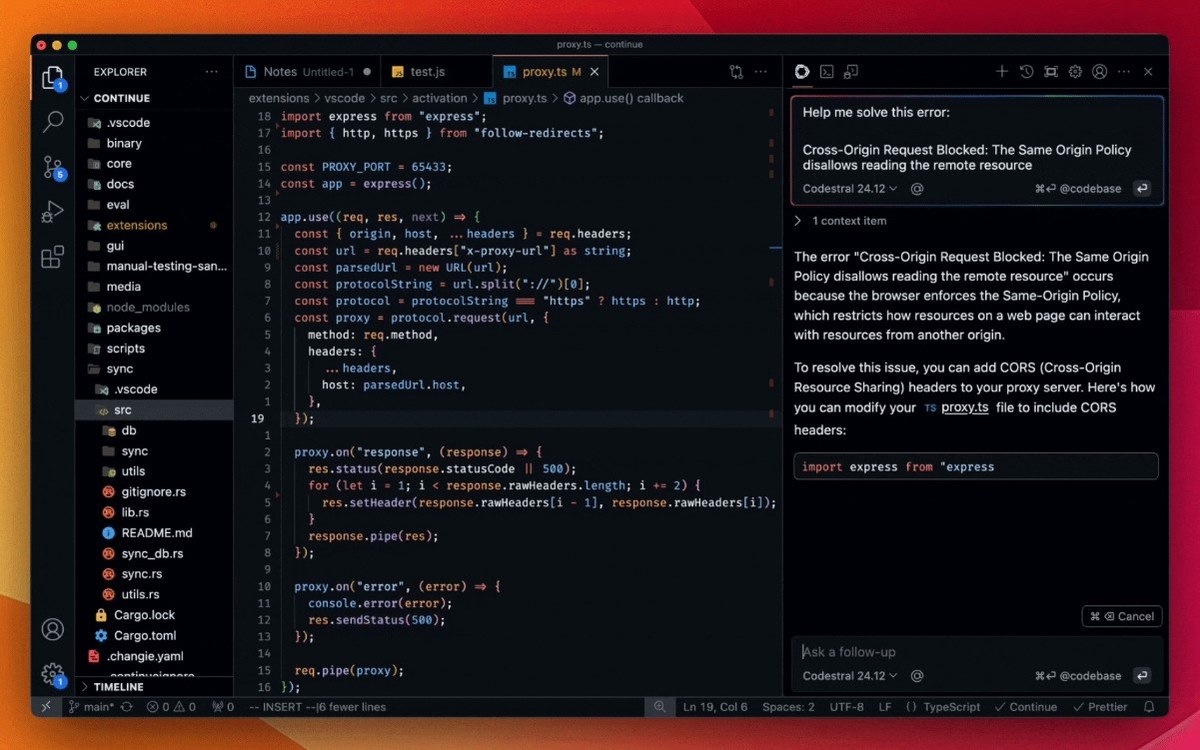

Для тих, хто зацікавлений у випробуванні Codestral 25.01, модель доступна через плагіни IDE для таких платформ, як VS Code та JetBrains.